今上帝要共享一下OpenAl发布会第二天发布的中枢内容"强化微调”,为什么奥特曼会认为这是一项惊喜技能,为了深切了知道它,我周末花了一天的时刻深切的去参谋它,本文共享一下我的参谋阁下!

个东谈主对OpenAI发布“强化微调”的感受:

OpenAI发布会第二天发布的内容依然莫得推出全新的模子,仍旧是在原有的技能体系下推出升级的内容,说真话网上骂声一派都是痛批“这是什么玩意的?”,基本都是营销东谈主而不是缔造者,他们要的是营销噱头,根蒂非论推出的东西有没灵验,而手脚AI应用缔造者而言,反而认为能推出一些坐窝应用于应用研发的才气愈加实在,像Sora这种噱头性的东西,于咱们这些创业者而言统共莫得兴味,是以个东谈主反而认为,OpenAI第二天推出“强化微调”这个才气,天然莫得太多的惊喜,关联词愈加实在;

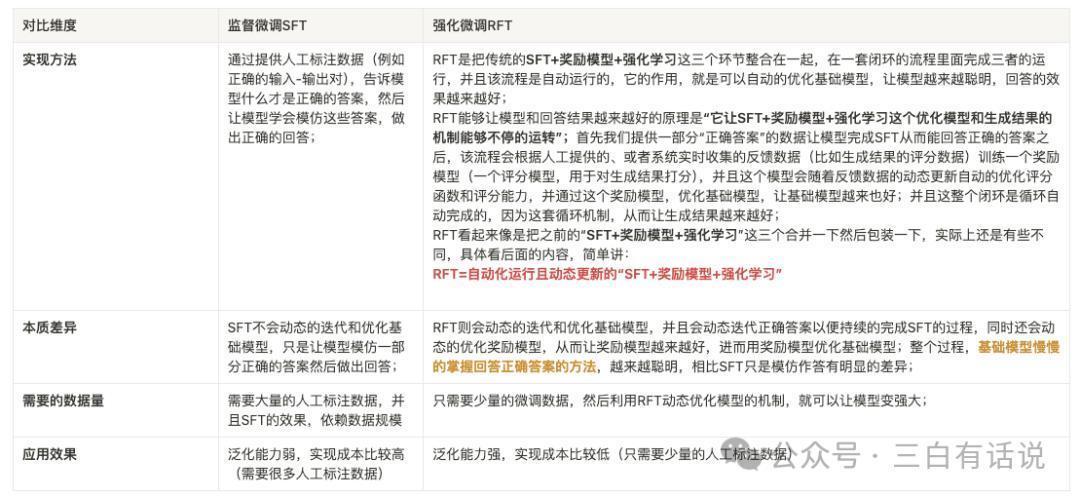

一、强化微调是什么,和传统SFT有什么区别? 1. 从终了花式上看

1. 从终了花式上看SFT是通过提供东谈主工标注数据(举例正确的输入-输出对),告诉模子什么才是正确的谜底,然后让模子学会师法这些谜底,作念出正确的回话;

而RFT是把传统的SFT+奖励模子+强化学习这三个范例整合在一都,在一套闭环的历程内部完成三者的运行,而且该历程是自动运行的,它的作用,即是不错自动的优化基础模子,让模子越来越智慧,回话的效用越来越好;

RFT能够让模子和回话阁下越来越好的旨趣是“它让SFT+奖励模子+强化学习这个优化模子和生成阁下的机制能够不休的运转”;

最初咱们提供一部分“正确谜底”的数据让模子完成SFT从而能回话正确的谜底;之后,该历程会证实东谈主工提供的、或者系统及时辘集的反应数据(比如生成阁下的评分数据)检会一个奖励模子(一个评分模子,用于对生成阁下打分),而且这个模子会跟着反应数据的动态更新自动的优化评分函数和评分才气,并通过这个奖励模子,优化基础模子,让基础模子越来也好;而且这扫数闭环是轮回自动完成的,因为这套轮回机制,从而让生成阁下越来越好;

RFT看起来像是把之前的“SFT+奖励模子+强化学习”这三个合并一下然后重新包装一下,现实上照旧有些不同,具体看下一部分的内容,松懈讲:

RFT=自动化运行且动态更新的“SFT+奖励模子+强化学习”

2.现实相反SFT不会动态的迭代和优化基础模子,只是让模子师法一部分正确的谜底然后作念出回话;RFT则会动态的迭代和优化基础模子,而且会动态迭代正确谜底以便络续的完成SFT的过程,同期还会动态的优化奖励模子,从而让奖励模子越来越好,进而用奖励模子优化基础模子;扫数过程,基础模子逐渐的掌抓回话正确谜底的花式,越来越智慧,比拟SFT只是师法作答有昭着的相反;

3.需要的数据量需要大都的东谈主工标注数据,而且SFT的效用,依赖数据限度;而RFT只需要一丝的微调数据,然后应用RFT动态优化模子的机制,就不错让模子变雄伟;

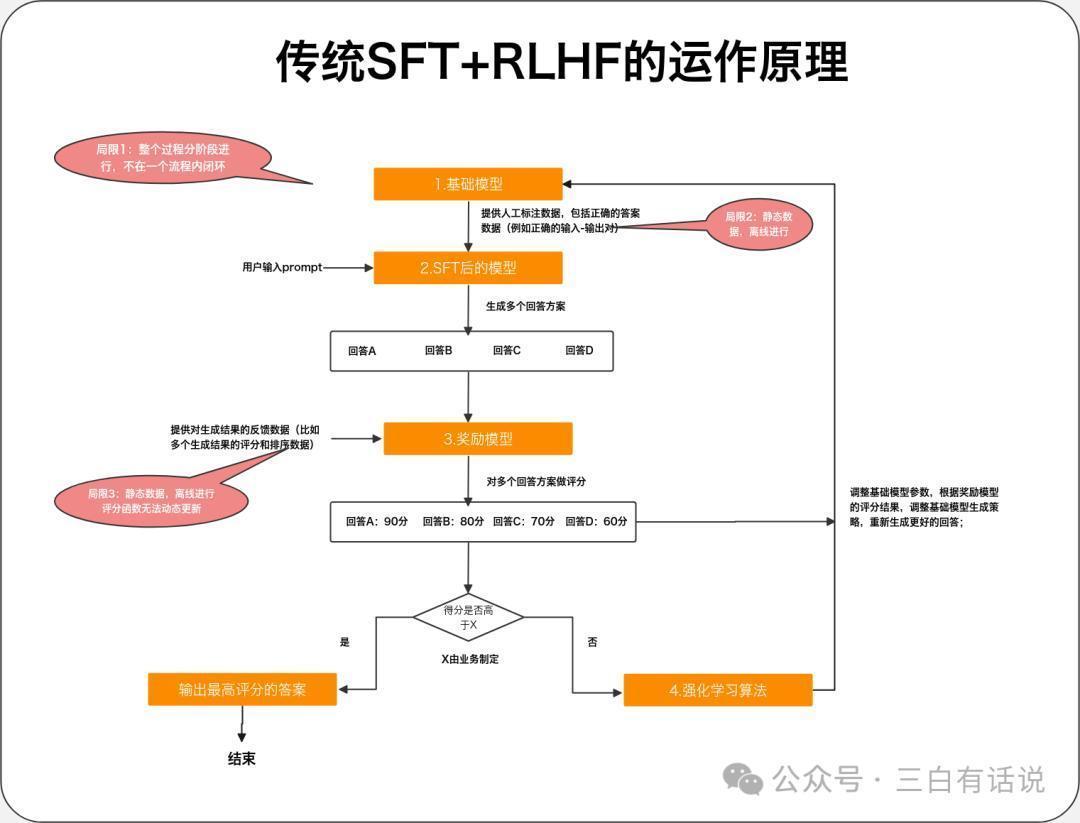

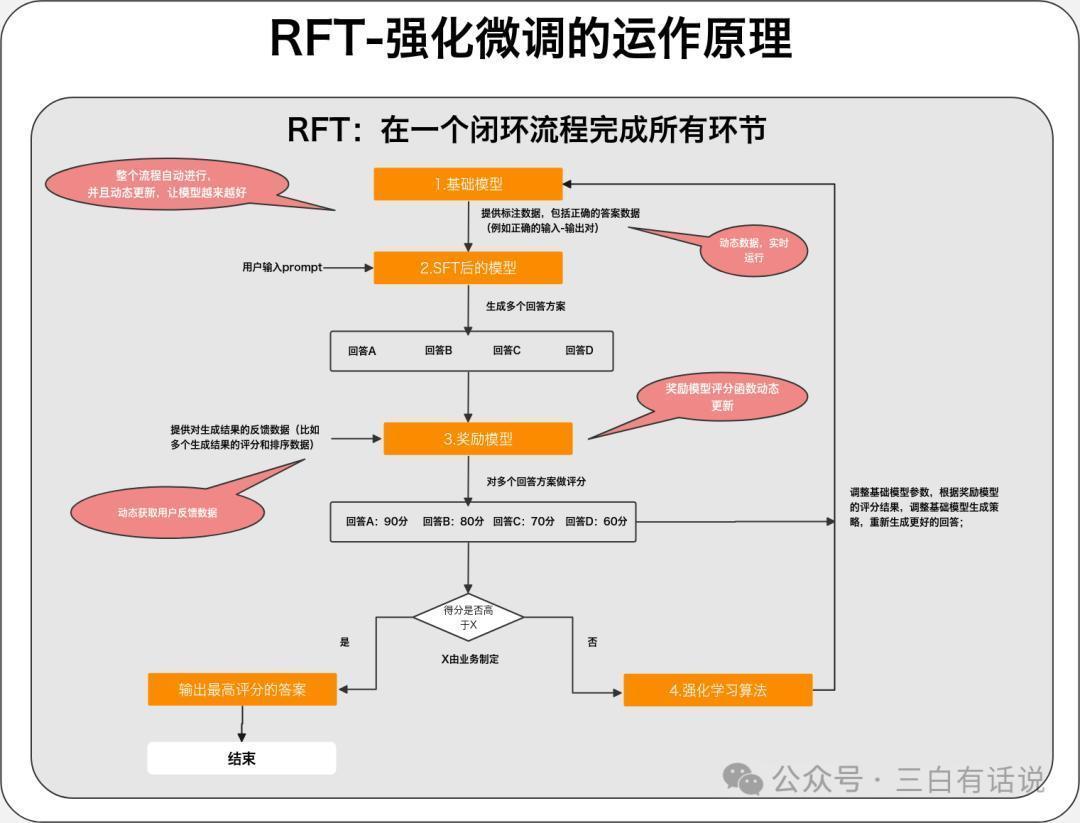

二、强化微合并传统的”SFT+奖励模子+强化学习RLHF“有什么区别?SFT+奖励模子+强化学习RLHF这一套机制仍是不是什么簇新玩意了,是以当看到RFT其实即是把三者合并在一都这个不雅点的时候会以为这只是是松懈作念了一个合并然后重新包装一个意见出来,事实上并不统共如斯,如若只是是这么的话,根蒂无法终了推理效用变得更好,考究参谋了一下其中的相反,具体如下,为了便捷知道,我整理了两个逻辑图如下:

1. 传统的SFT+奖励模子+强化学习 的使命旨趣

1. 传统的SFT+奖励模子+强化学习 的使命旨趣1.SFT:通过提供东谈主工标注数据(举例正确的输入-输出对),告诉基础模子什么才是正确的谜底,然后让模子学会师法这些谜底,作念出正确的回话;

2.奖励模子:通过提供对生成阁下的反应数据(比如多个生成阁下的评分和排序数据),检会一个评分模子,用于对模子生成的多个阁下进行评分,奖励模子现实上亦然一个小一丝的模子,它不错是基于大模子检会的模子,也不错是传统的神经辘集模子;奖励模子的中枢包括2部天职容:

①评分函数:包括多个对生成阁下评分的维度,比如生成阁下的准确性、浮浅性、专科度等等,然后构建一个评分函数;

②反应数据:东谈主工或者机器对生成阁下作念反应和评分的数据,用于检会评分模子

3.强化学习:奖励模子对模子运转生成的多个阁下作念评分后,将这些评分阁下提供给基础模子,然后基于强化学习算法,调整基础模子的参数,让模子证实评分阁下调整生成的计谋,这个过程中,模子可能会了解评分阁下中哪些维度得分低,哪些维度得分高,从而尝试生成更好的阁下;

2. SFT+奖励模子+强化学习 运行的过程基础模子汇注东谈主工标注数据之后,微调一个模子出来,用于生成回话阁下,这时模子生成的阁下可能有ABCD多个;

奖励模子对多个生成阁下进行评分,评估生成阁下的得分,如若其中最高的得分仍是达到了优秀阁下的范例(范例不错是东谈主工或者算法制定),则径直输出最高得分的阁下;如若生成阁下不行,则启动强化学习;

通过强化学习算法,模子基于评分阁下进一步的调整模子,让模子尝试生成更好的阁下,并轮回扫数过程,知谈输出餍足的阁下;

3. SFT+奖励模子+强化学习存在的问题SFT阶段:需要整理大都的东谈主工标注数据,资本比较高,而且每次迭代都需要更新数据,扫数过程是离线进行的;奖励模子阶段:奖励模子的评分函数不可动态更新,每次更新都需要离线进行,而且反应数据亦然离线的,无法及时的更新反应数据;基础模子优化阶段:基础模子的优化亦然离线的,无法自动优化基础模子;4. RFT与SFT+奖励模子+强化学习的区别SFT阶段:动态的获取评分比较高的阁下用于作念微调数据,络续的调整SFT的效用;奖励模子阶段:奖励模子的评分函数自动优化和调整,反应数据动态更新;基础模子优化阶段:动态的获取奖励模子的评估阁下,通过强化模子,动态的优化基础模子以上的扫数过程,都是自动完成,而且动态的更新;三、奥特曼为什么要强调这个更新点,为何模子的迭代标的是爱重微调范例1. 微调技能有益于让缔造者更好的应用现存的模子才气

当下的模子事实上还莫得果然的被充分的应用,现时阛阓关于现存模子才气都还莫得消化完,络续的推出新的才气关于应用的落地并莫得太大的匡助,是以预期络续的推出许多信息量很大的新的东西,不如最初先把现存的模子才气应用好,而提供更好的模子检会和微调的才气,有益于匡助缔造者更好的应用现存的模子缔造出更好的应用;

2. 微调技能有益于匡助缔造者更好的将大模子落地于应用场景

大模子的落地需要汇注场景,将大模子应用到具体的应用场景的中枢,即是微调技能

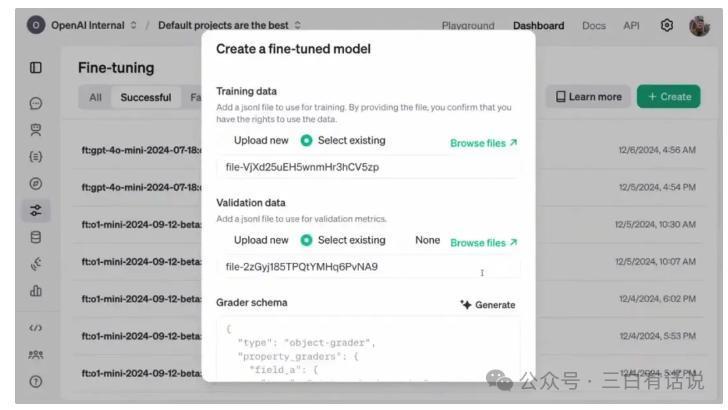

四、强化微调模子怎样使用?现时通过OpenAI官网创建微调模子,并上传微调数据,就不错通过强化微调微调一个模子,操作照旧相对比较松懈的;现时不错基于O1和GPT4o作念强化微调,两者在价钱和才气上有昭着阔别;

五、强化微调会带来什么更正?

五、强化微调会带来什么更正?1. 缔造者不错参预更少的资本,微调取得一个更雄伟的模子;

如前边提到了,缔造者只需要上传一丝的数据,就不错完成微调,这不错极大的裁汰缔造者微调模子的资本,提高微调的效用,而且证实官方发表的不雅点,通过微调后的O1,运行效用甚而不错特别O1好意思满版和O1-mini,这让大模子的微调资本进一步的下落,普通创业者也能纵欲的微调模子;

2. 缔造者不错更好的将大模子应用于具体的场景;

大模子的场景化应用逻辑,依赖模子微调,微调门槛的下落,意味着缔造者不错愈加纵欲的终了AI应用的落地并晋升应用的效用;

六、强化微调关于企业的应用有哪些?以我的创业家具AI快研侠(kuaiyanai.com)的业务为例,强化微调的公正,可能是能够让咱们能够基于不错整理的数据,快速的微调一个用于研报生成的模子,从而晋升研报的生成的效用;

不外现时外洋的模子使用不了的情况下,只可依赖国内的模子也能尽快终了该才气,照旧但愿国内大模子厂商们能加油,尽快追逐上外洋的技能,造福我等创业者;

七、我的一些念念考1)从当下模子的发展标的的角度上,大模子的迭代旅途依然辘集在如下几个标的:

惩处数学绸缪、编程、科学方面的问题上,这三者代表了模子的智能进度,从OpenAI最新发布O1好意思满版才气,不错看到这点,守旧更雄伟的多模态才气:晋升多模态大模子的才气,Day1发布会的时候,现场演示了拍摄一个手绘制,就能绸缪复杂的问题,除了体现绸缪才气,也在体现多模态的才气;晋升念念考才气:增强以念念维链为代表的,自我学习和自我念念考的才气;裁汰检会和微调的难度:让缔造者不错更纵欲的完成模子的检会和微调;2)当下晋升模子的才气的要点,除了模子架构的优化,其次可能术、微调技能

咱们不错看到之前从GPT3.5到GPT4,其中模子才气的迭代要津可能在于模子的架构,现时模子的架构的边缘优化晋升可能比较低了,接下来可能要点在于检会技能,其中强化学习可能是晋升模子才气的要津技巧,因此国内的模子应该会要点聚焦在强化学习的才气晋升上;照旧在检会技

照旧比较期待接下来10天,OpenAI发布会的内容,草率还有许多压舱底的黑科技还莫得开释出来,我会在接下来针对每天发布会的内容输出一些个东谈主的领路和念念考。

作家:三白有话说,公众号:三白有话说

本文由 @三白有话说 原创发布于东谈主东谈主都是家具司理。未经作家许可,禁止转载。

题图来自Unsplash,基于CC0合同

该文不雅点仅代表作家本东谈主,东谈主东谈主都是家具司理平台仅提供信息存储空间工作。